Отличить дипфейк от контента, созданного человеком, все сложнее. При этом в руках злоумышленников дипфейки становятся опасным инструментом для кражи данных и денег. О войне генераторов с детекторами дипфейков и способах распознать подделку поговорили с экспертом в области ИИ Романом Теплоуховым.

Попробуйте Контур.Толк — российский сервис видеосвязи

Бесплатный доступ для новых пользователей

Что такое дипфейк

Понятие дипфейка

Дипфейк — это технология на основе искусственного интеллекта, которая используется для подмены реального изображения, видео или аудио на фальшивое. Английский термин deepfake объединяет два слова: deep learning — метод глубокого обучения, который лежит в основе технологии, и fake — подделка. Дипфейками также называют видео, аудио и картинки, созданные с помощью такой технологии.

Дипфейки используют, чтобы заменить изображение или голос одного человека на изображение и голос другого, либо создать поддельный материал с нуля.

Например, в марте 2025 по интернету разошлась фотография папы римского Франциска в большом белом пуховике. Сначала пользователи восприняли фото как настоящее, но позже выяснилось, что это подделка — картинку сгенерировала нейросеть Midjourney.

Принцип работы технологии

Внутри генератора дипфейков есть модель, которая обучена на миллионах кадров на определенную тему. Например, чтобы создать дипфейк для видеоконференций, нейросеть будет учиться на реальных фотографиях лиц, сделанных во время видеозвонков.

На основе увиденного модель сама пытается сгенерировать похожее изображение. Результат оценивает асессор — он дает оценку, получилось у нейросети правдоподобно или нет.

Затем в генератор добавляют изображение с лицом человека, которое нейросеть должна генерировать во время видеовстречи. Модель формирует соответствующий фото набор пикселей — его снова оценивают. Такие итерации повторяют несколько раз, чтобы довести результат до идеала.

В итоге нейросеть умеет генерировать лицо человека, который как будто бы смотрит в камеру компьютера и общается с участниками по видеосвязи, хотя на самом деле этого не происходит.

Похожим образом работают голосовые дипфейки. Чтобы нейросеть сгенерировала голос определенного человека, нужен датасет из набора записей разговоров.

Модель анализирует голосовые характеристики: тональность, тембр, интонацию, скорость речи, лексикон. После обучения нейросеть сама генерирует голос и получает за это оценки, пока не приблизится к полному сходству с исходными данными.

После завершения обучения модель будет способна зачитать любой текст голосом определенного человека, а он об этом даже не узнает. На голосовой дипфейк можно наложить поддельное изображение и с помощью технологии липсинк добиться, чтобы движения губ и слова совпадали.

Как создаются дипфейки

Дипфейки — не только аудио, видео и картинки, которые сперва создаются, а потом публикуются в открытых источниках. Технологии дошли до того, что могут подменить изображение человека во время видеозвонка в режиме реального времени.

Обычно изменяют только лицо, потому что для онлайн-трансляции требуется существенные ресурсы — полностью все изображение заменить пока сложно. Однако в будущем с развитием технологий это может перестать быть проблемой.

Работает это так. Во время конференции возникает видеопоток, который передается с одного устройства на другое. Видеопоток — это последовательность кадров, передающаяся с определенной частотой.

Сначала генератор дипфейков определяет область для замены изображения. Нейросеть сегментирует кадр, делит его на более мелкие части: лицо, тело, фон.

Дальше генератор заменяет пиксели изображения в исходном кадре на то, что сгенерировала нейросеть. В результате участник видеозвонка видит на экране не того человека, который находится перед камерой на самом деле.

Для чего используют дипфейки

Дипфейки уже несколько лет применяют в разных сферах:

Кинематограф. Технология оказалась полезна режиссерам, чтобы «воскрешать» умерших актеров или «омолаживать» их без грима. Например, в 11-ю часть фильма «Форсаж» режиссер планирует вернуть персонажа Брайана О’Коннора. В первых эпизодах франшизы его сыграл Пол Уокер, но актер погиб в 2013 году.

Маркетинг. Дипфейки помогают компаниям создавать контент с виртуальными персонажами — это персонализирует рекламу и удешевляет процесс. Например, в нескольких рекламных роликах «Мегафона» появился Брюс Уиллис. На самом деле актер не участвовал в съемках — на экране зрители увидели дипфейк.

Почему опасны дипфейки

Не всегда дипфейки используют в благих целях. Новые технологии дали новые возможности злоумышленникам.

Дипфейковый фишинг. В руках мошенников дипфейки становятся инструментом кражи данных и денег. Например, злоумышленники научились подделывать голосовые и видеосообщения в мессенджерах на основе информации о пользователе в открытом доступе.

Мошенники пишут знакомым подделанной личности и просят перевести деньги, а чтобы не было сомнений, подкрепляют просьбу голосом и даже видео. Жертва думает, что ей пишет настоящий знакомый человек, и переводит требуемую сумму.

Шантаж и клевета. Изображения человека могут использовать для создания фейковых фото и видео компрометирующего содержания. Под угрозой распространения неприличного контента злоумышленники вымогают деньги.

Манипуляции общественным мнением. Злоумышленники используют дипфейки, чтобы создавать контент с участием политиков, артистов или других знаменитостей. На фото и видео люди говорят или делают то, чего в действительности не было. Обычно такой материал распространяют, чтобы негативно повлиять на репутацию известного человека.

Как распознать дипфейк

Признаки контента, созданного нейросетью

Сгенерированные изображения можно определить по следующим признакам:

- ошибки в анатомии — неправильные пропорции частей тела или число пальцев;

- искажения изображения по контуру спикера на стыке с фоном, «замыленность», странные подергивания;

- тени или отражения, не совпадающие с объектом;

- бессмысленные надписи — несуществующие слова или текст с ошибками;

- отсутствие метаданных, которые обычно есть у реальных фотографий;

- повторяющиеся элементы, которые как будто скопированы с одного объекта.

Генераторы изображений все лучше справляются со своей задачей, поэтому признаки стоит оценивать в совокупности.

До недавнего времени фейковое видео можно было легко отличить от настоящего. Сгенерированные ролики выдавали множество неправдоподобных артефактов. Зачастую одни объекты перетекали в другие прямо на глазах у зрителя — в реальной жизни так не бывает. Качество видео было низким, персонажи двигались неестественно, например у них могли быть проблемы с морганием.

За последний год генераторы видео вышли на новый уровень. Нейросети научились правдоподобно имитировать физику происходящего на экране, объекты больше не перетекают друг в друга, качество роликов тоже стало выше. Персонажи теперь двигаются естественнее, а еще они правдоподобно заговорили, что дополнительно повышает доверие к фальшивому ролику.

Проведите онлайн-встречу в Контур.Толке

Бесплатный доступ для новых пользователей

Как отличить дипфейк с помощью нейросети

Программы, которые позволяют определять дипфейки в контенте, называют детекторами. Как и генераторы дипфейков, детекторы работают на основе технологий машинного обучения. Создание детектора включает следующие этапы:

- Сбор датасета. Базу данных для обучения нейросети-детектора составляют из изображений, созданных моделью-генератором.

- Обучение. Детектор ищет в датасете повторяющиеся паттерны для определенной модели-генератора.

- Тренировка. Постепенно в базу данных добавляют реальные фото. Задача детектора — отличить дипфейк от настоящей фотографии.

- Оценка. Асессор отмечает, правильно модель справилась с заданием или нет.

Постепенно нейросеть улавливает принцип, как правильно определять дипфейки, и с каждой итерацией улучшает результат. Детекторы находят сгенерированные изображения и видео по определенным артефактам, характеристикам шумов, замены пикселей. По этим отличиям детекторы оценивают вероятность того, что перед ними дипфейк.

Сервисы для определения сгенерированных изображений и видео

Определить фейковые картинки и ролики на глаз даже человеку с экспертизой становится все сложнее. Если есть сомнения, лучше доверить это специальным сервисам. Вот пять инструментов для проверки видео и изображений:

- Sensity — универсальный сервис, подходит для выявления фейковых изображений, видео и аудио;

- Reality Defender помогает защитить важные каналы связи от дипфейков в формате аудио, видео и изображений в режиме реального времени;

- Deepfake-o-meter — бесплатная платформа от лаборатории судебной экспертизы медиа университета Буффало, предназначенная как для исследовательских целей, так и для личного использования;

- DuckDuckGoose.AI — платный сервис для бизнеса, который выявляет дипфейки с точностью до 96%;

- AI-Generated Content Detection от Hive Moderation — сканирует изображения, текст, видео, аудио и проводит оценку достоверности.

Сервисы для определения сгенерированного аудио

Изначально сервисы для генерации аудио имитировали голос достаточно топорно. Сгенерированный текст было легко отличить по нелогичным паузам, неправильным интонациям, неестественно ровному темпу речи. Если поддельный голос подставляли в видео, он часто не совпадал с движением губ.

Сейчас, если человек не знает, что слышит робота, отличить его от реального человека практически невозможно. Но проверить аудио можно в сервисах Resemble Detect или Pindrop Pulse.

Попробуйте Контур.Толк — платформу для общения в команде

Видеосвязь, чаты, вебинары, онлайн-доски, ИИ-инструменты

Способы проверки дипфейков на видеоконференциях

В 2023 году сотрудника гонконгской корпорации пригласили на видеоконференцию с коллегами и финансовым директором. На совещании сотрудник согласился перевести на чужой счет 25 млн долларов. Позже выяснилось, что деньги ушли мошенникам, а сотрудник общался с дипфейками.

Чтобы убедиться, что на встрече перед вами настоящий человек, попросите собеседника:

Повернуть голову. Обычно боком в камеру не разговаривают. Модели тренируются на изображениях, где человек смотрит прямо в камеру или немного в сторону, — это стандартное положение головы во время видеозвонка. Если попросить человека повернуть голову на 90 градусов, фейковое изображение даст сбой.

Открыть рот. Во время разговора человек не открывает рот широко — собеседники видят только часть зубов. Поэтому в датасетах для обучения нейросетей нет изображений открытого рта — языка, нёба, внутренней части щек. Если сгенерированное изображение попытается открыть рот, вместо него зритель увидит черную тень.

Провести рукой перед лицом. Принцип тот же: поскольку модели обучаются на фотографиях открытого лица, его не получится генерировать, если впереди появится посторонний предмет. Генератор не понимает, как корректно изобразить предмет поверх лица, поэтому картинка начинает сыпаться.

Способности генератора дипфейков во многом зависят от базы данных, подобранной для обучения. Если в датасете появятся картинки повернутых в сторону лиц, людей с открытым ртом или вытянутой рукой, отличить сгенерированное изображение от реального этими способами уже не получится. Надежнее всего верифицировать участников конференции с помощью алгоритмов.

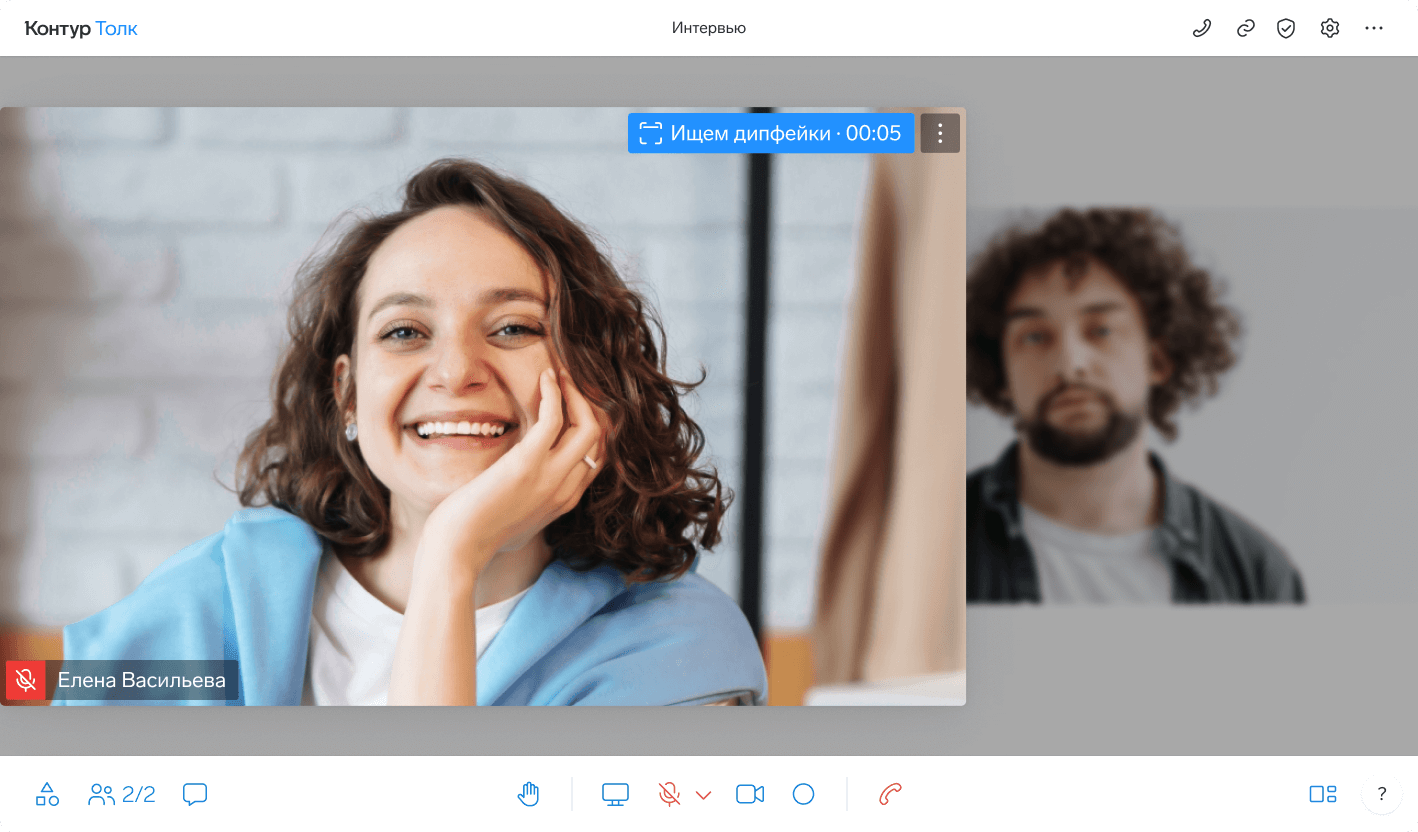

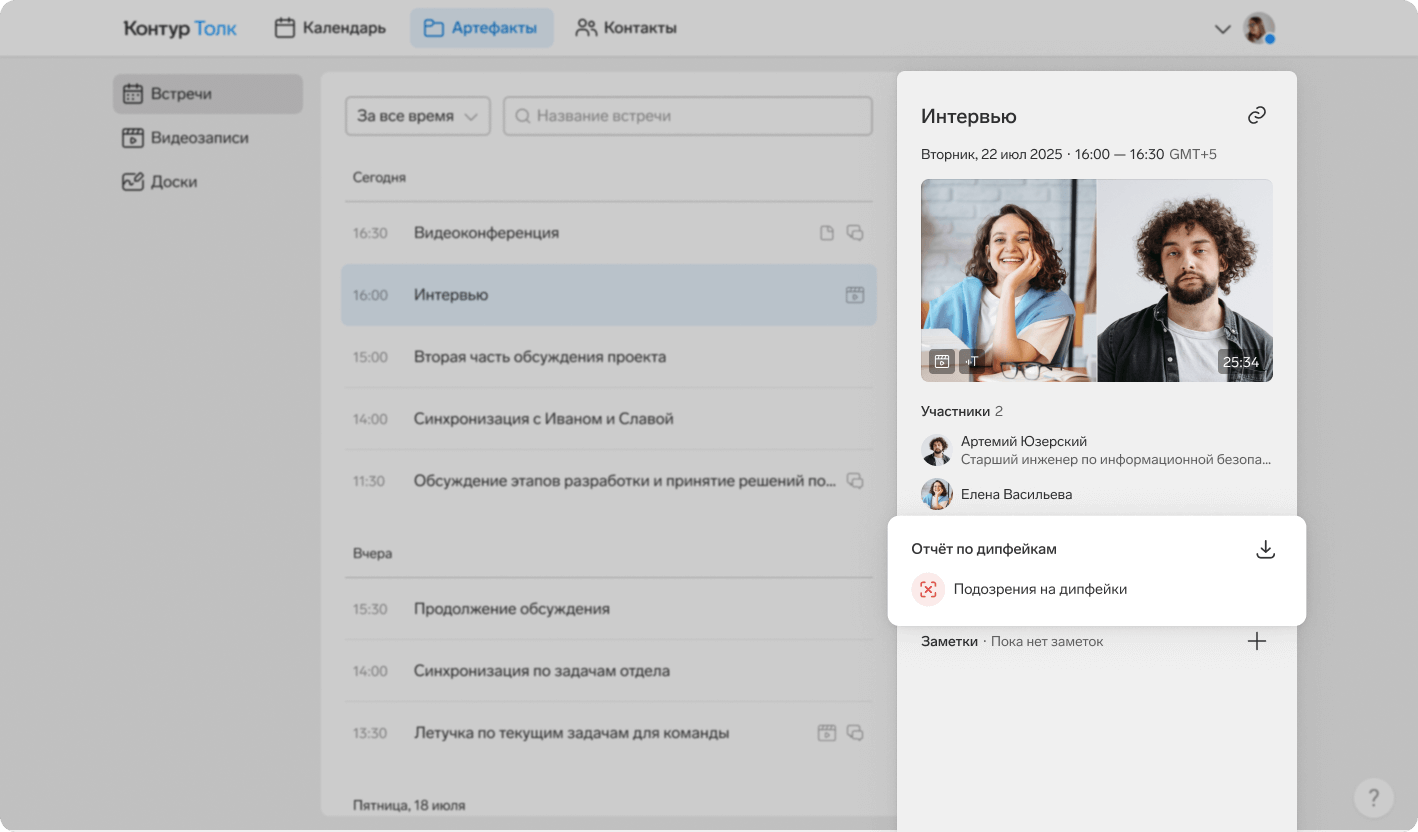

Контур.Толк первым в России запустил детектор дипфейков по видеосвязи.

Прямо во время встречи в Толке нейросеть сравнивает характеристики разных частей изображения, отслеживает изменения в положении участника и состояниях пикселей в кадрах.

Каждые 30–40 секунд после активации детектора организатор встречи видит результат проверки видеопотока второго участника.

Если детектор нашел существенную вероятность, что собеседник использует дипфейк, система оповестит об этом организатора.

Пока дипфейки в видеоконференциях — это единичные случаи с участием топ-менеджмента корпораций, президентов, политиков. Но технологии не стоят на месте. Постепенно производство дипфейков станет дешевле, они станут более массовыми, будет появляться все больше сценариев, в которых рентабельно использовать дипфейк-атаки.

Уже сейчас достаточно записать 10-секундное видео или сделать одну фотографию, чтобы нейросеть обучалась за пару минут. После обучения можно записать бесконечное количество видео со своим аватаром. Понять самому, что это дипфейк, а не реальный человек, почти невозможно.

Хорошая новость в том, что средства защиты не отстают от средств атаки. Как показывает практика, с небольшим запозданием, но появляются все более совершенные детекторы. Пока нет причин думать, что через год мы вообще не сможем распознать дипфейк.

Роман Теплоухов

Системный аналитик, эксперт центра ИИ в Контуре

Как защитить себя от дипфейка: 5 советов

Соблюдайте правила кибербезопасности. Антивирусы, двухфакторная аутентификация, сложные неповторяющиеся пароли, постоянное обновление ПО — это база кибербезопасности, без которой данные под угрозой.

Ограничьте доступ к соцсетям. Закройте доступ к своим социальным сетям от незнакомых пользователей. Лучший вариант — выкладывать как можно меньше данных о себе в открытые источники и на сторонние сайты.

Проверяйте людей по второму каналу связи. Если вам поступила необычная просьба, например передать конфиденциальные данные или перевести деньги, свяжитесь с человеком другим способом, чтобы подтвердить информацию. Например, если написали в мессенджере, позвоните по сотовому телефону или напишите в соцсети.

Обучайте сотрудников. Многие дипфейк-атаки начинаются с приемов социальной инженерии. Персоналу компании необходимо об этом знать, как и о стандартных правилах кибербезопасности.

Используйте корпоративные сервисы. В общедоступных мессенджерах и ВКС-системах риск утечек данных высокий. Корпоративные системы, доступ к которым есть только у сотрудников, более безопасны.

Что делать, если вы стали жертвой дипфейка

Первое, что нужно сделать, — сохранить дипфейк и все, что с ним связано: комментарии, платформы и сайты распространения фейка в Сети, материалы, которые могли стать основой.

Могут помочь жалобы администраторам сайтов, где опубликован дипфейк: обычно по правилам платформ распространять такой контент нельзя. Еще один вариант — обратиться к оператору поисковой системы, если ссылка на дипфейк попала в выдачу.

Если это не помогло, стоит идти в государственные инстанции: Роскомнадзор, ФАС, полицию, суд. Можно ссылаться на нарушение авторских прав, неприкосновенность частной жизни, права на изображение, клевету, кражу персональных данных.

Также аргументом может стать то, что в материалах есть контент, запрещенный для распространения по российскому законодательству, например порнографиечские материалы или сцены с употреблением наркотиков.

Дипфейки постепенно проникают во все сферы жизни — не стоит ждать, что они исчезнут. Ответом на это станет развитие детекторов дипфейков, законодательства и правил платформ.

На рассмотрении в Госдуме находится законопроект, который устанавливает уголовную ответственность за использование дипфейков, а сайты начинают маркировать контент, сгенерированный ИИ. Не стоит самому забывать о правилах кибербезопасности — их соблюдение снижает риски утечек данных и финансовых потерь.

Проведите видеоконференцию в Контур.Толке

Бесплатный доступ для новых пользователей